Extractos de la entrevista a Daniel Bogoya Maldonado por Eduardo Montoya.

Evaluación Educativa y Aseguramiento del Aprendizaje.

La educación superior contemporánea enfrenta un fenómeno paradójico: a pesar de décadas de implementación de evaluaciones estandarizadas, las brechas de calidad persisten con una estabilidad desconcertante. Cuando analizamos los resultados de pruebas como Saber Pro – TyT, emerge una estructura aparentemente inmutable en la que ciertas instituciones se posicionan sistemáticamente en los rangos superiores, otras en niveles intermedios, y un tercer grupo permanece anclado en zonas de rezago significativo.

Esta configuración no es producto del azar; responde a culturas institucionales profundamente arraigadas y, fundamentalmente, a la manera en que cada institución comprende, procesa y utiliza la información que las evaluaciones le proporcionan. Más preocupante aún resulta constatar la existencia de brechas profundas al interior de las propias instituciones. Si examinamos el cuerpo estudiantil de una universidad, encontramos distancias significativas entre quienes alcanzan los niveles de desempeño más destacados y aquellos que se encuentran en situación de rezago.

Asimismo, emergen diferencias sistemáticas entre programas académicos: algunos mantienen consistentemente estudiantes con desempeños sobresalientes, mientras que otros replican historias de resultados precarios. Esta realidad interna constituye el verdadero desafío de la calidad educativa, pues revela que, incluso dentro de un mismo ecosistema institucional, las oportunidades de aprendizaje no se distribuyen equitativamente.

El desenlace académico de un estudiante resulta predecible con considerable anticipación. Cinco años antes de que un estudiante culmine un programa profesional, su ruta esperada ya está determinada en gran medida si la institución no interviene de manera deliberada. Esta capacidad de avizorar el futuro no debe conducirnos al fatalismo, sino a la responsabilidad institucional.

Las universidades formulan promesas sociales ambiciosas sobre el perfil de egreso, pero pocas se cuestionan con rigor qué proporción de estudiantes satisface realmente esa promesa. Como señala Daniel Bogoya: “Si logramos identificar tempranamente el estado de desarrollo de competencias y proyectar su trayectoria, tenemos la obligación ética de diseñar intervenciones que modifiquen ese itinerario y garanticen que cada estudiante alcance los estándares comprometidos. Esto solo es factible mediante sistemas institucionales de evaluación científicamente diseñados que proporcionen información confiable, válida y oportuna”.

El problema de los sesgos evaluativos y la necesidad de instrumentos científicos.

La problemática de los sesgos representa uno de los obstáculos más insidiosos para el aseguramiento del aprendizaje. Con frecuencia, las evaluaciones institucionales oscilan entre dos extremos igualmente perjudiciales: o son excesivamente benévolas, generando calificaciones infladas que crean una falsa sensación de dominio, o son desmedidamente severas, produciendo resultados bajos no porque el estudiante carezca de competencias, sino porque el instrumento presenta fallas de calibración.

Un estudiante puede transitar exitosamente por el sistema interno gracias a evaluaciones laxas, pero al enfrentar un examen de Estado o incorporarse al mercado laboral, se confronta con una realidad para la cual su institución no lo preparó. La construcción de instrumentos científicamente fundamentados descansa sobre tres pilares inseparables: confiabilidad, validez y consistencia.

Un instrumento de medición robusto debe arrojar resultados equivalentes cuando mide el mismo objeto, independientemente de las iteraciones de su aplicación. En la evaluación educativa, cinco pruebas diferentes sobre un mismo dominio —literatura, por ejemplo—, si están adecuadamente diseñadas desde parámetros psicométricos rigurosos, deberían revelar resultados consistentes sobre el nivel de competencia del estudiante. El error común radica en creer que al cambiar la prueba necesariamente cambian los resultados, cuando, en realidad, los instrumentos válidos y confiables convergen en diagnósticos similares.

No obstante, la confiabilidad técnica no es suficiente. La validez exige que midamos con exactitud aquello que pretendemos medir, aplicando el instrumento a la población adecuada. Dependiendo de si trabajamos con la Teoría Clásica de los Test o la Teoría de Respuesta al Ítem (TRI) —y dentro de esta última, si utilizamos modelos de uno, dos o tres parámetros considerando dificultad, discriminación y azar—, emergerán diferentes indicadores de validación.

Un aspecto crucial, frecuentemente descuidado, es la necesidad de poblar adecuadamente la escala de medición. Si un instrumento presenta vacíos entre ciertos niveles, se generan «zonas ciegas» donde resulta imposible detectar con precisión el estado de desarrollo estudiantil. Diseñar instrumentos que recorran sistemáticamente todo el espectro de complejidad cognitiva requiere un conocimiento especializado sobre constructos y procesos cognitivos específicos.

La pregunta fundamental que debemos plantearnos es: cuando asignamos a un estudiante una puntuación específica, ¿esa calificación es precisa y confiable, o existe un margen de error considerable? Si certificamos que un estudiante domina la argumentación cuando en realidad solo ha desarrollado capacidades analíticas y posteriormente le solicitamos producir un ensayo argumentativo, fracasará no por incompetencia personal, sino por un error diagnóstico institucional. De ahí la importancia crítica de poseer claridad absoluta sobre qué proceso cognitivo evalúa cada ítem y asignar puntuaciones coherentes con dichos procesos.

Del diagnóstico a la acción: intervenciones en la zona de desarrollo próximo:

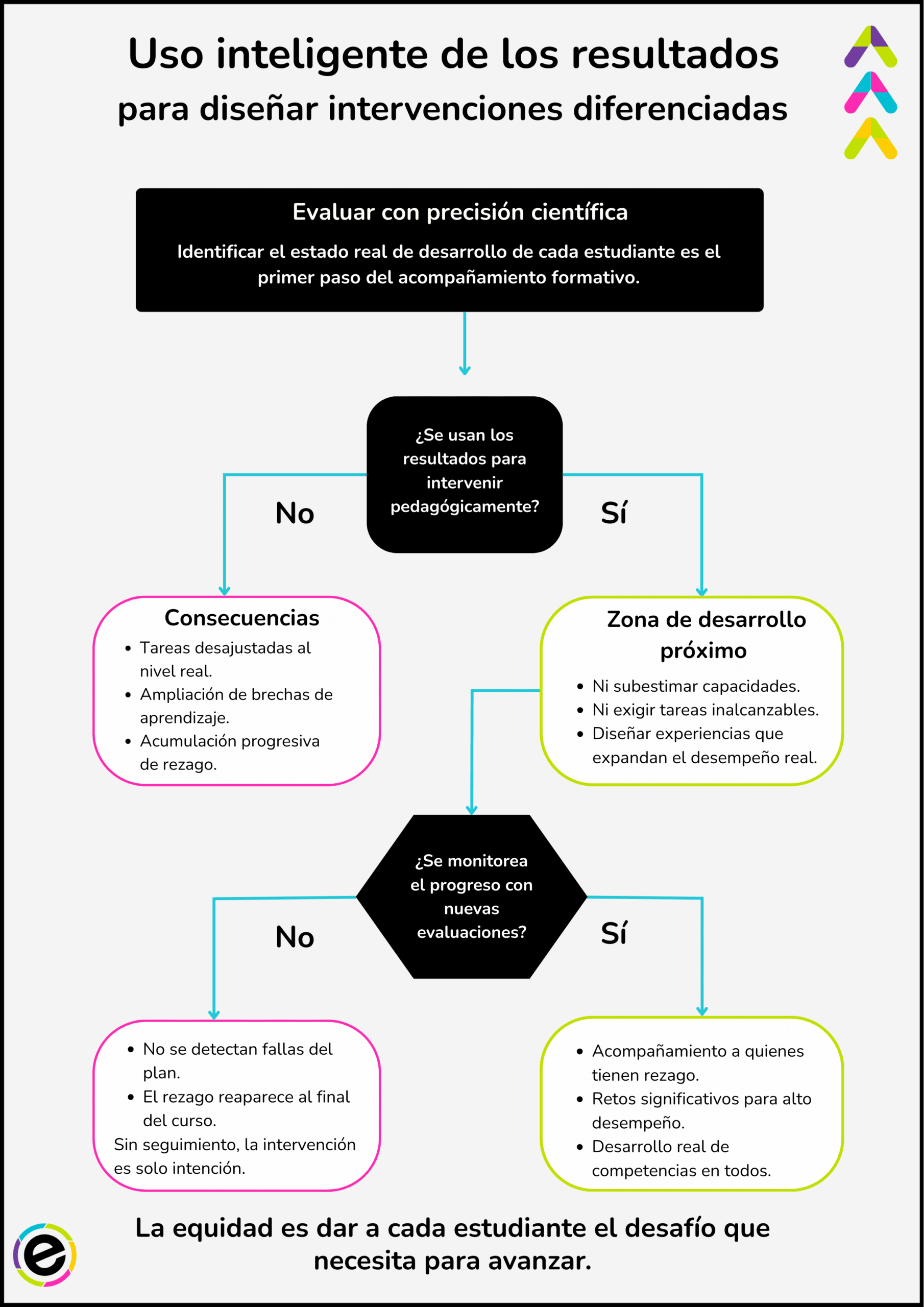

La precisión técnica cobra pleno sentido pedagógico cuando las instituciones utilizan inteligentemente los resultados para diseñar intervenciones diferenciadas. Si identificamos que un estudiante se encuentra en el nivel de análisis, resulta contraproducente exigirle tareas argumentativas complejas que excedan su capacidad actual.

El uso inteligente de los resultados consiste en identificar el modo actual de desempeño para ubicarnos en su zona de desarrollo próximo, diseñando experiencias que amplíen sus capacidades sin subestimarlas ni sobreestimarlas. El riesgo de no adoptar este enfoque es evidente: cuando en un curso planteamos a todos una tarea compleja que solo algunos pueden realizar, no retamos equitativamente, sino que ampliamos las brechas existentes.

Los estudiantes que ya dominan competencias superiores avanzan, mientras quienes aún no alcanzan esos niveles simplemente acumulan rezago. Este fenómeno de acumulación progresiva representa uno de los principales dramas educativos en el contexto latinoamericano. Un estudiante ingresa con cierto nivel de desventaja, se le plantean tareas que no comprende, sobrevive quizás apoyándose en sus pares, pero al finalizar el curso las brechas se han ensanchado y sus capacidades reales no han crecido proporcionalmente.

La evaluación científicamente diseñada permite identificar con precisión el estado de cada estudiante. Pero esta identificación es solo el primer paso. Si en la fase inicial de un semestre realizamos una evaluación diagnóstica rigurosa e identificamos estudiantes con rezago significativo, corresponde diseñar planes diferenciados de acompañamiento.

Sin embargo, el diseño del plan no garantiza per se su eficacia. Al cabo de un tiempo, es imperativo confirmar mediante nuevas evaluaciones si las estrategias están funcionando o requieren ajustes. Esta lógica de monitoreo sistemático permite correcciones sobre la marcha y evita llegar al final de un programa con la sorpresa de que el estudiante no desarrolló las competencias esperadas.

Aquí emerge una advertencia fundamental que hace el experto: no podemos abandonar a los estudiantes de alto desempeño mientras concentramos recursos en quienes presentan rezagos. Si un estudiante ya domina la argumentación y le asignamos tareas meramente descriptivas, lo subestimamos y generamos frustración. La justicia educativa implica dar un poco más a quien más lo necesita, pero sin descuidar el potencial de nadie. Una vez identificado el estado de desarrollo de cada estudiante, corresponde ubicarnos en su respectiva zona de desarrollo próximo: ni tareas triviales para niveles altos, ni tareas inalcanzables para niveles básicos.

Evaluación como laboratorio de hábitos y compromiso ético profesional.

Los datos de evaluación revelan patrones que trascienden lo meramente académico y tocan dimensiones éticas profundas. Cuando aparecen correlaciones negativas —es decir, cuando estudiantes responden correctamente a tareas complejas sin haber respondido adecuadamente tareas sencillas—, los indicadores de consistencia alertan sobre anomalías: respuestas al azar, copia o falta de compromiso genuino.

La respuesta institucional apropiada no debe ser punitiva, sino dialógica. Corresponde conversar con el estudiante, explicarle la teoría de validación, escuchar sus apreciaciones y construir conjuntamente una comprensión del proceso evaluativo como un ejercicio de aprendizaje. Debemos evitar las jerarquías de evaluadores que ordenan y evaluados que obedecen, promoviendo en su lugar diálogos entre roles diferenciados que comparten horizontes comunes.

Este punto resulta crucial porque la evaluación funciona como un laboratorio que revela no solo conocimientos, sino también hábitos, valores y disposiciones personales. Una persona que frente a un instrumento de evaluación no ofrece respuestas auténticas, que evade u omite, deja entrever un patrón conductual que probablemente se manifestará en su desempeño profesional. La falta de compromiso con la evaluación académica anticipa, frecuentemente, una falta de compromiso con las responsabilidades laborales futuras.

Por ello, las universidades tienen la responsabilidad ineludible de formar profesionales con compromiso ético. Esto exige que los propios profesores y directivos asuman la evaluación con convicción genuina, evitando transmitir mensajes escépticos que erosionen la legitimidad del proceso. Si los docentes cuestionan públicamente la utilidad de la evaluación, resulta previsible que los estudiantes adopten esas mismas actitudes.

La coherencia institucional requiere que quienes evalúan acepten también ser evaluados, modelando así el hábito de autoevaluación esperado. La educación opera fundamentalmente por el ejemplo. Si pensamos algo, decimos otra cosa y actuamos de manera distinta, transmitimos incoherencia. La autenticidad pedagógica exige una consonancia estricta entre pensamiento, discurso y práctica.

Evaluación tradicional Versus Evaluación Científica.

| Característica | Evaluación Tradicional | Evaluación Científica (ESE) |

| Propósito principal | Clasificar y generar una calificación. | Asegurar el aprendizaje y cerrar brechas. |

| Instrumentos | Basados en intuición o severidad/laxitud. | Basados en parámetros psicométricos (TRI). |

| Uso de los datos | Veredicto final (éxito o fracaso). | Mapa para intervenir en la Zona de Desarrollo Próximo. |

| Métrica de éxito | Resultados absolutos (promedios). | Valor agregado (crecimiento del estudiante). |

| Rol del docente | Calificador y transmisor. | Investigador y modelo ético. |

| Ética | Control burocrático y jerárquico. | Compromiso con la promesa social de egreso. |

Valor agregado institucional: más allá de los resultados absolutos.

La cuestión del valor agregado y el aporte relativo resulta particularmente relevante para comprender las diferencias aparentes entre instituciones. Existen instituciones académicamente excluyentes que realizan una selección rigurosa en la admisión, recibiendo únicamente estudiantes que ya poseen niveles altos de preparación. En estos casos, los buenos resultados de egreso reflejan parcialmente los buenos insumos de entrada, y no necesariamente un valor agregado institucional excepcional. De hecho, en algunos casos, el desafío consiste simplemente en conservar los niveles con los que los estudiantes ingresan.

Paralelamente, existen instituciones académicamente incluyentes que reciben estudiantes con rezagos significativos derivados de deficiencias estructurales de la educación media. Evaluar su calidad únicamente por los resultados absolutos de egreso resulta profundamente injusto. El mérito se mide mejor por el valor agregado: cuánto crecen los estudiantes durante su trayectoria formativa, cuánto rezago logran compensar y cuántas brechas logran cerrar.

Una institución que recibe estudiantes con nivel A1 de inglés y los gradúa en B1 ha generado un valor agregado sustancial, aunque sus egresados no alcancen los niveles de instituciones que reciben estudiantes ya bilingües. Los perfiles institucionales diferenciados responden a visiones y promesas sociales específicas. No todas las universidades deben perseguir idénticos estándares en todas las áreas.

Algunas instituciones enfatizan las ingenierías y naturalmente destacan en razonamiento cuantitativo; otras priorizan las humanidades, desarrollando fortalezas en lectura crítica y escritura. El ejercicio de benchmarking no debe reducirse a comparaciones mecánicas de promedios generales, sino considerar grupos de referencia pertinentes según el perfil institucional y examinar el valor agregado además de los resultados absolutos.

Las brechas internas merecen una atención especial. Una institución genuinamente comprometida con el aseguramiento del aprendizaje debe preguntarse: ¿cuál es el saber mínimo que garantizaremos a cada egresado? En términos de procesos cognitivos, el nivel de análisis representa un piso razonable: la capacidad de desagregar conceptos, identificar sus elementos constitutivos, comprender sus relaciones y reconstruir el concepto completo. Esta habilidad permite evitar reduccionismos y navegar territorios disciplinarios con una comprensión genuina.

Hasta un 67% de los estudiantes responden cualitativamente diferente ante profesores que son autores, que han investigado, escrito y sometido su trabajo a la evaluación de pares ciegos.

Daniel Bogoya

Prácticas pedagógicas de alto impacto: investigación docente y escritura estudiantil.

La investigación docente emerge como una variable explicativa particularmente potente de los resultados estudiantiles. Análisis de correlaciones indican que cerca del 67% de la varianza en los resultados de Saber Pro – TyT se explica por la producción académica de los profesores en revistas indexadas. Esta asociación resulta más fuerte que factores socioeconómicos o de género.

Los estudiantes responden cualitativamente diferente ante profesores que son autores, que han investigado, escrito y sometido su trabajo a la evaluación de pares ciegos. Estos docentes enseñan desde un conocimiento que ellos mismos han construido, no desde la repetición mecánica de textos ajenos. Esa autenticidad intelectual conquista el interés genuino del estudiante.

Adicionalmente, el vínculo se fortalece cuando los estudiantes participan activamente en grupos de investigación desde etapas tempranas de su formación. Cuando asumen responsabilidades como levantar actas o contribuir al análisis y cuando la coautoría en publicaciones reconoce sus aportes, desarrollan modos de pensamiento radicalmente diferentes a quienes solo consumen conocimiento empaquetado.

La escritura estudiantil sistemática representa otra práctica de alto impacto frecuentemente descuidada. Si cada clase genera al menos una página de escritura reflexiva y el profesor retroalimenta periódicamente esas producciones, se establece una dinámica de aprendizaje profundo. Implementar estas prácticas no resulta sencillo; la respuesta pedagógica apropiada no es imponer autoritariamente, sino modelar con el ejemplo: si el profesor escribe y comparte su escritura, si demuestra vulnerabilidad intelectual y apertura a la crítica, gradualmente los estudiantes se animarán a participar.

Hacia el cierre de brechas: aseguramiento del aprendizaje como compromiso institucional.

Para Daniel Bogoya, el camino del análisis a la mejora institucional requiere identificar con precisión dónde se ubican los estudiantes en el espectro de desarrollo competencial. Esto implica mapear tanto a quienes están en la cima como, especialmente, a quienes presentan rezagos significativos, para diseñar planes intensivos de acompañamiento monitoreados sistemáticamente.

No se trata de abandonar los estándares altos, sino de aplicar una justicia de roles: dar un poco más a quien más lo necesita, trabajando intensivamente con los estudiantes rezagados para compensar la falta de oportunidades previas. Las universidades latinoamericanas enfrentan el desafío de transitar desde culturas evaluativas punitivas o meramente credencialistas hacia culturas evaluativas formativas centradas en el aseguramiento del aprendizaje.

Esto exige transformaciones en múltiples niveles: desarrollo de instrumentos técnicamente rigurosos, formación docente en evaluación científica, sistemas de información que permitan el seguimiento longitudinal de las trayectorias estudiantiles, estructuras de apoyo académico diferenciado y, fundamentalmente, cambios de mentalidad sobre el propósito mismo de la evaluación. Los resultados de pruebas estandarizadas no son veredictos inapelables, sino fotografías en un momento dado que deben interpretarse como insumos para decisiones de mejora.

Cuando una institución descubre que sistemáticamente repite posiciones en los rankings, la pregunta no es solamente cómo escalar posiciones, sino qué capacidades institucionales debe desarrollar para transformar genuinamente las experiencias de aprendizaje. Cuando identifica brechas internas significativas, debe preguntarse qué barreras invisibles las generan y cómo desmantelarlas. Cuando advierte que ciertos programas muestran desempeños consistentemente bajos, corresponde investigar las causas estructurales y diseñar intervenciones sistémicas.

La promesa de los sistemas institucionales de evaluación científicamente diseñados radica en su capacidad de proporcionar evidencia sólida para estas reflexiones y acciones. No se trata de generar más datos, sino de producir información interpretable, confiable, válida y oportuna que oriente decisiones pedagógicas, curriculares e institucionales fundamentadas.

Cuando estas decisiones se implementan sistemáticamente, monitoreadas rigurosamente y ajustadas de manera continua, las instituciones pueden cerrar brechas entre universidades, entre programas dentro de una misma universidad y entre estudiantes de un mismo programa. El uso inteligente de los resultados evaluativos trasciende la mera interpretación técnica de estadísticas para convertirse en un ejercicio ético y político de construcción de equidad educativa.

Cada dato sobre el desempeño estudiantil debe interrogarnos sobre qué hicimos o dejamos de hacer institucionalmente, qué oportunidades ofrecimos o negamos, y qué capacidades desarrollamos o descuidamos. La evaluación científicamente fundamentada no nos exime de responsabilidad, sino que hace esa responsabilidad más visible e ineludible. Nos coloca frente al espejo de nuestras prácticas y nos interpela sobre la coherencia entre nuestras promesas declaradas y nuestras acciones efectivas.

En ese sentido, los sistemas institucionales de evaluación no son instrumentos de control burocrático, sino herramientas de transformación pedagógica y compromiso social. Su valor no radica en los puntajes que producen, sino en las conversaciones, reflexiones y decisiones que provocan, y, en última instancia, en las vidas estudiantiles que ayudan a transformar hacia horizontes de mayor dignidad profesional y ciudadana.

Checklist: ¿Es su sistema de evaluación científicamente fundamentado?

Para terminar te invitamos a responder a este checklist. Te dará pautas para evaluar el sistema de evaluación de tu IE.

-

[ ] Validez de Constructo: ¿Existe claridad técnica sobre qué proceso cognitivo (análisis, síntesis, argumentación) evalúa cada ítem?

-

[ ] Confiabilidad Técnica: ¿El instrumento arroja resultados equivalentes en diferentes aplicaciones sobre el mismo dominio?

-

[ ] Calibración Psicométrica: ¿Se utilizan modelos de uno, dos o tres parámetros (dificultad, discriminación, azar) para validar los ítems?

-

[ ] Poblamiento de Escala: ¿El instrumento cubre todo el espectro de complejidad cognitiva o existen «zonas ciegas» donde no se puede medir al estudiante?

-

[ ] Identificación de la ZDP: ¿Los resultados permiten ubicar con precisión dónde termina la capacidad actual del alumno y dónde empieza su potencial de mejora?

-

[ ] Monitoreo de Intervención: ¿Se realizan nuevas evaluaciones tras las tutorías para confirmar si el plan de acompañamiento funcionó?

-

[ ] Análisis de Consistencia: ¿El sistema detecta anomalías (correlaciones negativas) que sugieran falta de compromiso o azar en las respuestas?

-

[ ] Cálculo de Valor Agregado: ¿La institución sabe cuánto avanzó realmente el estudiante en comparación con su nivel de ingreso?

-

[ ] Coherencia Institucional: ¿Los docentes participan en investigación y modelan la cultura de evaluación con su propio ejemplo?

Recuerda que en ESE aplicamos todo el rigor en nuestros simulacros y sistemas de evaluación.

Conoce nuestro artículo académico sobre:

Confiabilidad y Validez de los Instrumentos de Evaluación.

*Daniel Bogoya Maldonado ha sido consultor en educación por más de 30 años. Fue Decano en la Universidad Jorge Tadeo Lozano, profesor durante 32 años en la Universidad Nacional de Colombia sede Bogotá, director del Icfes por cuatro años (liderando la creación de las pruebas ECAES, hoy Saber Pro) y Coordinador técnico del LLECE.

0 comentarios