Hasta el momento hemos abarcado dos características elementales de una Evaluación, como lo son la Validez y la Confiabilidad.

Con ello tenemos una evaluación blindada que mide con precisión lo que queremos medir. Ahora, luego de aplicar las evaluaciones, hay información sumamente valiosa sobre el proceso de formación que estamos llevando a cabo.

Es por ello que debemos hacer, tanto a nivel individual como a nivel grupal, un análisis, interpretación y uso de los resultados que obtenemos de cada evaluación que aplicamos.

Muchos docentes piensan que para poder realizar el análisis de los resultados hay que ser un estadista o saber mucha matemática.

Otros piensan que es necesario el uso de programas densos o del manejo experto de cierto software educativo para extraer esta información, y no es así. Contar con esos recursos seguramente traerá beneficios, pero nosotros mismos podemos llevarlo a cabo con herramientas básicas de manejo de datos, como por ejemplo, Excel.

No hay manera más eficiente de explicar que con un caso práctico, de hecho, de eso se trata la formación por competencias. La evaluación con la que se llevará a cabo el análisis consta de un total de 16 ítems aplicada a un grupo de 30 estudiantes, en el diseño de los ítems se le adjudicó un nivel de dificultad a cada uno y se estableció una distribución de la siguiente manera:

Tabla 1: Distribución de los niveles de dificultad de los ítems en la evaluación diseñada

Ítem 1 al Ítem 5 | Nivel Bajo |

Ítem 6 al Ítem 12 | Nivel Medio |

Ítem 13 al Ítem 16 | Nivel Alto |

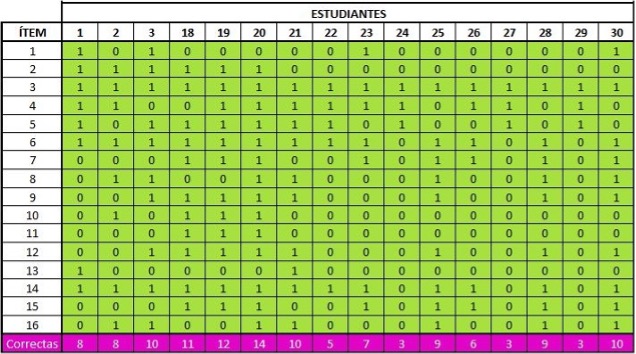

En la figura 1 se muestra un cuadro donde se ha vaciado la información (para entendimiento gráfico se han agrupado un conjunto de columnas en el programa de Excel), cada estudiante cuenta con un número asignado, puede ser por apellido o por el orden en el que entregaron las evaluaciones. Se le ha asignado un uno (1) al ítem que se ha respondido correctamente y un cero (0) al que no. Al final de cada columna estamos contando la cantidad de respuestas correctas que el estudiante ha tenido en la evaluación, se puede observar en la fila inferior de la tabla en donde aparecen las respuestas correctas totales de cada estudiante.

Figura 1: Respuestas correctas e incorrectas de los estudiantes.

Automáticamente por lógica se podría decir que si la evaluación fue de 16 ítems, el estudiante debe tener como mínimo 8 respuestas correctas para poder aprobar. Sin embargo, eso es relativo, depende si el docente ha colocado o no el mismo puntaje para cada ítem independientemente del nivel de dificultad, y adicionalmente a ello, que todos los ítems hayan sido válidos y confiables dentro de la evaluación.

¿Recuerdas cuando conversamos en el módulo 1 sobre los niveles de dificultad de los ítems dentro de una evaluación y de cómo establecerlos de manera objetiva? Si no sabes de qué estamos hablando, conoce nuestro curso modular en Diseño de Instrumentos de Evaluación.

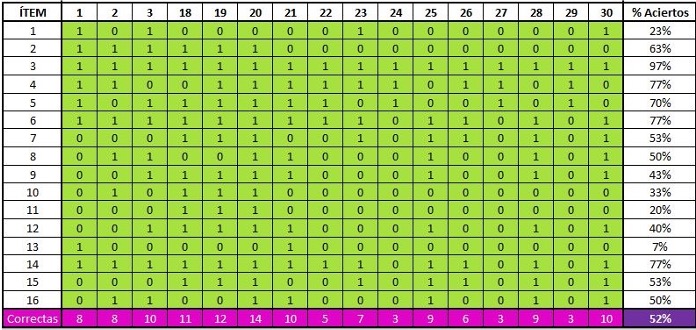

En la figura 2, se puede ver el porcentaje de aciertos que ha tenido cada ítem dentro del grupo de estudiantes. Al final es una proporción, si para él ítem 1 se tienen que en total 7 estudiantes han contestado correctamente de un total de 30, allí se establece que hay un 23% de aciertos. El hecho de que el porcentaje de aciertos sea bajo, el nivel de dificultad va aumentando; es una proporcionalidad inversa. A diferencia del ítem 3, que 29 estudiantes de 30 lo han contestado correctamente dejando un porcentaje de aciertos del 97%, eso implica que él ítem es de nivel sumamente bajo. De hecho, casi el total de estudiantes han acertado, más adelante lo vamos a profundizar cuando veamos intervención de un ítem post-evaluación.

Figura 2: Porcentaje de aciertos para cada ítem

En el módulo 1 se establecieron unos rangos de porcentajes de aciertos para establecer el nivel de dificultad de los ítems. Si se tiene un ítem en donde el 70% o más responden correctamente, ese ítem es de nivel Bajo. Un ítem en donde la población que responde adecuadamente es mayor o igual al 30% y menor al 69%, ese ítem es de nivel Medio. En cambio, si se tiene un ítem en donde menos del 29% de los estudiantes responden correctamente, ese ítem es de nivel Alto. Se establecieron los extremos (0% y 100%) como ítems que nadie responda correctamente o que todos respondan de manera correcta; estos ítems no suministran información sobre el proceso evaluativo. En la tabla 2 se muestra la distribución de los porcentajes de aciertos para cada nivel de dificultad sin tomar en consideración la intervención de un ítem (se le llamó X al porcentaje de aciertos)

Tabla 2: Porcentaje de aciertos para cada nivel de dificultad SIN intervención de los ítems post-evaluación

Nivel Bajo | 70% ≤ x ≤ 99% |

Nivel Medio | 30% ≤ x < 69% |

Nivel Alto | 1% ≤ x < 29% |

Ítem anulado si | x = 0% ó x = 100% |

Ahora bien, en este módulo vamos a profundizar sobre las intervenciones de los ítems y cuando debemos hacerlo, tomando en consideración los resultados estadísticos.

Los extremos dentro de la escala son delicados a nivel de validez y confiabilidad en la evaluación, por ello, el porcentaje que definamos para realizar la intervención de un ítem va a depender de la cantidad total de estudiantes que tengamos en un grupo. Para nuestro caso, y como sugerencia, se deja un rango de 10% para decidir cuándo se debe intervenir un ítem, ya que analizando ese porcentaje nos transmite que la pregunta no está del todo clara, los distractores son fácilmente descartables o es muy obvia la alternativa correcta. En otras palabras, ese ítem no está bien diseñado. Quedaría de la siguiente manera la distribución de los niveles de dificultad:

Tabla 3: Porcentaje de aciertos para cada nivel de dificultad tomando en consideración la intervención de los ítems post-evaluación

Nivel Bajo | 70% ≤ x ≤ 90% |

Nivel Medio | 30% ≤ x < 69% |

Nivel Alto | 10% ≤ x < 29% |

Intervenir ítem si | x < 10% ó x > 90% |

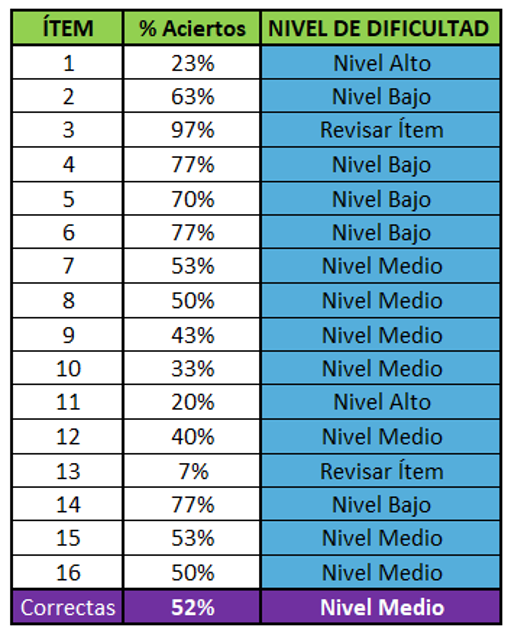

Volviendo con el ejemplo, en la figura 3 se muestran los niveles de dificultad que se han obtenido en cada ítem según los resultados de los estudiantes. Recuerdas que según el diseño de la evaluación, los cinco primeros ítems fueron de nivel bajo, los siete siguientes ítems de nivel medio y los cuatro últimos de nivel alto. Esta información le transmite al docente que algunos ítems no están cumpliendo realmente con su propósito. De 16 ítems, se deben intervenir 2 por cuestiones de diseño. Eso hace que el total de ítems válidos y confiables para emitir un resultado de aprendizaje a un estudiante son en realidad catorce.

Figura 3: Niveles de dificultad reales de cada ítem

De esos 14 ítems, hay cuatro de nivel bajo, ocho de nivel medio y solamente dos de nivel alto. Para una próxima evaluación se debe reorganizar la distribución del nivel de dificultad de los ítems para que cumpla con la evaluación, haciendo el diseño de los ítems con niveles de dificultad que falten. A esto se le conoce como “balanceo” de la batería o del instrumento.

Hasta el momento se ha hecho la interpretación de los niveles de dificultad de los ítems según los resultados generales de la evaluación. Tomando ese análisis en consideración, se pueden chequear los resultados obtenidos por cada estudiante para que de esa forma haya un soporte cuantitativo del nivel de desempeño que éstos poseen.

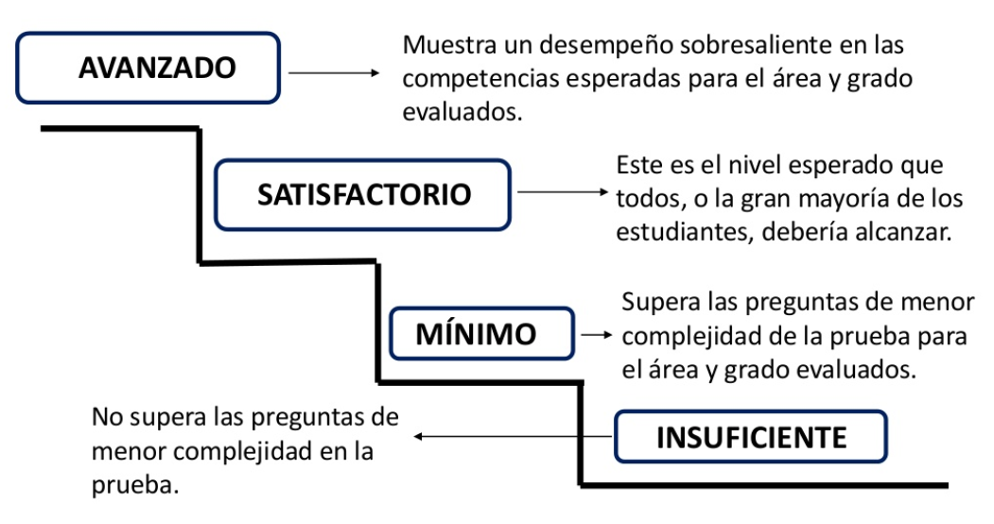

Un nivel de desempeño va más allá de haber aprobado la evaluación o no, al final es detectar el manejo indudable de una evidencia o qué tan lejos se encuentran los estudiantes de alcanzarla. Va de la mano de lo que se ha hablado previamente en módulos anteriores sobre una evaluación para el aprendizaje y la forma en que se suministra la devolución de los resultados a los estudiantes. Se tienen cuatro niveles de desempeño: Insuficiente, Mínimo, Satisfactorio y Avanzado. Se podría decir que la frontera entre aprobar o no la evaluación se encuentra entre el nivel Mínimo y Satisfactorio, mientras que el nivel Insuficiente y Avanzado se van alejando hacia los extremos.

En la figura 4 se muestran las descripciones genéricas de los niveles de desempeño según el Instituto Colombiano para el Fomento de la Educación Superior (ICFES). El nivel de desempeño depende entonces de las evidencias que se desean rastrear dentro de la evaluación y de la cantidad de ítems que utilicemos para ello.

Figura 4: Descripción genérica de cada nivel de desempeño según ICFES

Tabla 4: Distribución de los Niveles de Desempeño

Avanzado | x ≥ 80% |

Satisfactorio | 50% < x < 79% |

Mínimo | 20% < x ≤ 49% |

Insuficiente | x ≤ 19% |

En la tabla 4 se muestra el porcentaje de desempeño que tiene el estudiante según sus resultados. Para tener un nivel de desempeño satisfactorio no basta con cumplir exactamente con el 50% de la evaluación, se debe en teoría superar ese valor. Por ejemplo, para nuestra evaluación de 14 ítems con validez y confiabilidad, debe tener al menos 8 correctas superando así el 50% del total. Pero no debemos usar siempre un promedio simple, como le veremos enseguida.

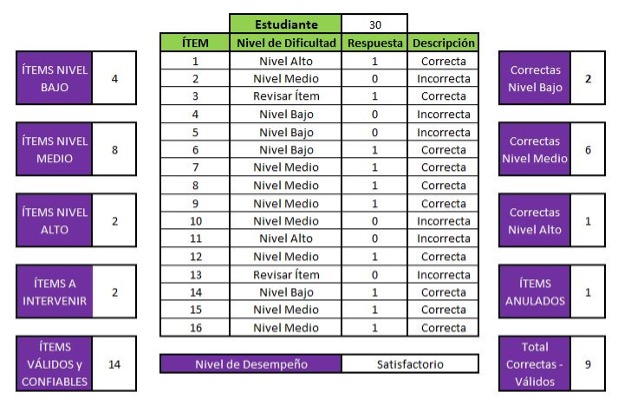

Tomando como ejemplo al estudiante número 30 del grupo, figura 5, éste ha respondido de manera correcta 10 ítems de los 16 que tuvo la evaluación. En el lado izquierdo de la figura se muestran la cantidad de ítems que tuvo la evaluación para cada nivel de dificultad, así como los ítems anulados en el análisis y el total de ítems validados y confiables que se toman en consideración para la calificación final. Para el estudiante, hay 2 ítems correctos fueron de nivel bajo. Para el nivel medio, respondió correctamente 6 ítems, mientras que para los 2 ítems de nivel alto ha respondido uno solo.

Figura 5: Análisis de los resultados individuales de los estudiantes.

Hasta allí el estudiante tiene realmente tiene 9 ítems correctos debido a que no se toma en cuenta el ítem número 3 que respondió correctamente pero que no suministra información clave de su aprendizaje. Esto quiere decir, que anulando del total los dos ítems a intervenir, este estudiante ha respondido correctamente 9 ítems de 14. Según lo conversado previamente, se concluye que tendría un nivel de desempeño: Satisfactorio. No obstante, interpretando los ítems que éste ha respondido correctamente, causa curiosidad la distribución de las respuestas correctas que tuvo ese estudiante según los niveles de dificultad de los ítems.

De cuatro ítems de nivel bajo, ha respondido sólo dos. Mientras que de los ocho ítems de nivel medio ha respondido seis. Para los ítems de nivel alto, de los dos que había, respondió uno. No tiene mucho sentido que solo responda dos ítems de nivel bajo y el resto sea de nivel medio o alto. Allí se está detectando una incongruencia en sus resultados. Lo más lógico sería que para tener 9 ítems correctos, responda todos los ítems de nivel bajo que son cuatro más otros cinco ítems de nivel medio. En conclusión, ahí se ha detectado un posible fraude o respuestas al azar. La devolución de los resultados personalmente a este estudiante permitirá establecer conclusiones sobre su aprendizaje con fundamentos. A esto se le denomina correlación positiva o correlación negativa en la evaluación.

De esa forma se debe realizar el análisis de los resultados de las evaluaciones para cada uno de los estudiantes. Las conclusiones serán de manera cuantitativa y plenamente objetivas. Como docentes debemos tener estrategias para evitar que nuestras evaluaciones tengan respuestas al azar. Para ello, se recomienda realizar ítems que tengan preguntas de control. Estas preguntas llevan una secuencia con un nivel de dificultad creciente. De esa manera, si no responde un ítem que está preguntando algo sencillo, es imposible que el estudiante me dé la respuesta correcta del ítem donde se pide algo mucho más avanzado.

Si deseamos con base en lo explicado, mejorar el análisis e interpretación de los resultados de una evaluación, podemos asignar valores diferentes a casa ítem, revisando siempre que exista una correlación entre los ítems, sus respuestas correctas y sobre todo, su nivel de dificultad.

Para finalizar, como docentes debemos medir el Valor Agregado que hemos suministrado a un grupo de estudiantes durante un proceso formativo. Nos permite conocer cuánto agregamos al aprendizaje esperado de los alumnos. Una de las herramientas que se recomienda, es tener una evaluación inicial y una evaluación final para el grupo de estudiantes. Lo que se conocen como las evaluaciones diagnósticas, estas evalúan todo lo que los estudiantes deben manejar al finalizar el proceso formativo. Estas evaluaciones, con igualdad de características y distribución, nos permiten saber cómo llegan los estudiantes y cómo se van. Nos da información a nosotros del valor que hemos agregado a su formación.

BIBLIOGRAFÍA

- American Educational Research Association (AERA), American Psychological Association (APA), & National Council on Measurement in Education (NCME), 2014. Standards for educational and psychological testing. Washington: American Educational Research Association.

- CENTRO DE MEDICIÓN MIDE UC. (2011). Preguntas liberadas pruebas SEPA 2009 – 2010. Recuperado de http://www.sepauc.cl/wp-content/uploads/2014/09/Preguntasliberadas-2009-2010.pdf

- Instituto Colombiano para el Fomento de la Educación Superior (ICFES). http://www.icfes.gov.co

- Instituto Nacional para la Evaluación de la Educación (INEE). Confiabilidad, validez e imparcialidad en una evaluación educativa. México (2014)

- Martínez Arias, M. R. (1995). Psicometría. Teoría de los tests psicológicos y educativos. Madrid, España: Síntesis.

- MESSICK, S. (1995). Standards of validity and the validity of standards in performance asessment. Educational Measurement: Issues and Practice, 14(4), 5-8.

- Ruiz Bolívar, C. (2002). Instrumentos de Investigación Educativa.

Escrito por: Equipo ESE. Revisado por Eduardo Montoya Castañeda – Director general ESE – Latam.

0 comentarios